文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

小鹏的1024科技日已经举办到了第四届 , 连续4年关注下来 , 科技日的内容也越来越丰富 , 也十分有看头 。 在今年的活动上 , 小鹏直接罗列出了今年的四大主题:智能驾驶、智能交互、智能机器人和飞行汽车 。

其实小鹏每年1024科技日的重头戏都是智能驾驶 。

从2019年的XPILOT 2.5 , 到后来的XPILOT 3.0 , 再到具备VPA记忆泊车、高速和城市NGP功能的XPILOT 3.5 , 的确让越来越多人有机会直观感受到智能辅助驾驶技术的魔力 , 而“载体”也从最早的G3 , 到后来的P7以及首款搭载激光雷达的P5 。 可以看出小鹏新车型的推出 , 都是会伴随着智能驾驶技术的升级迭代的 。

不久前小鹏G9发布的时候也首次发布了XNGP全场景辅助驾驶功能 , 而G9各MAX版本上搭载的就是XPILOT 4.0硬件 。

小鹏XNGP可以按照“全场景”的字面意思 , 简单直接粗暴地理解为“所有路况和场景下都能使用的导航辅助驾驶功能” 。 对于大多数用户来讲 , 最直观的感知就是 , 日后只要开车出发前设定好导航并激活XNGP功能 , 车子就能一直“自动”开到目的地停车场 , 并且最终自动驶入停车位停好 。

【会飞的车,真的要来了?】可以讲 , XNGP如果最终真的按小鹏计划中的2024年落地 , 那无论XNGP名字上叫不叫“自动驾驶” , 实际体验上已经是高度自动化了 。

如果你了解小鹏的驾驶辅助功能 , 你就会知道 , 目前城市NGP功能之所以落地进展未如预期 , 很大程度上是因为“卡”在高精地图上了 。 一方面是政策对高精地图数据采集和使用的监管越来越严格 , 而另一方面是高精地图数据的更新频率始终无法跟上城市基建和道路变化的速度 。

就像一场开卷考试 , 如果那天的考试科目是物理 , 但你进了考场才发现带的是化学书 , 那让给你翻书还有意义吗?

所以实现XNGP把“无高精地图区域的导航驾驶”放在了第一位 。 这非常好理解 , 如果你本身已经随时具备考满分的学霸体质 , 考试时又何须浪费时间去翻书呢?自己直接答题远比翻书快了 。

高精地图已经沦为了配角 , 甚至可有可无 。

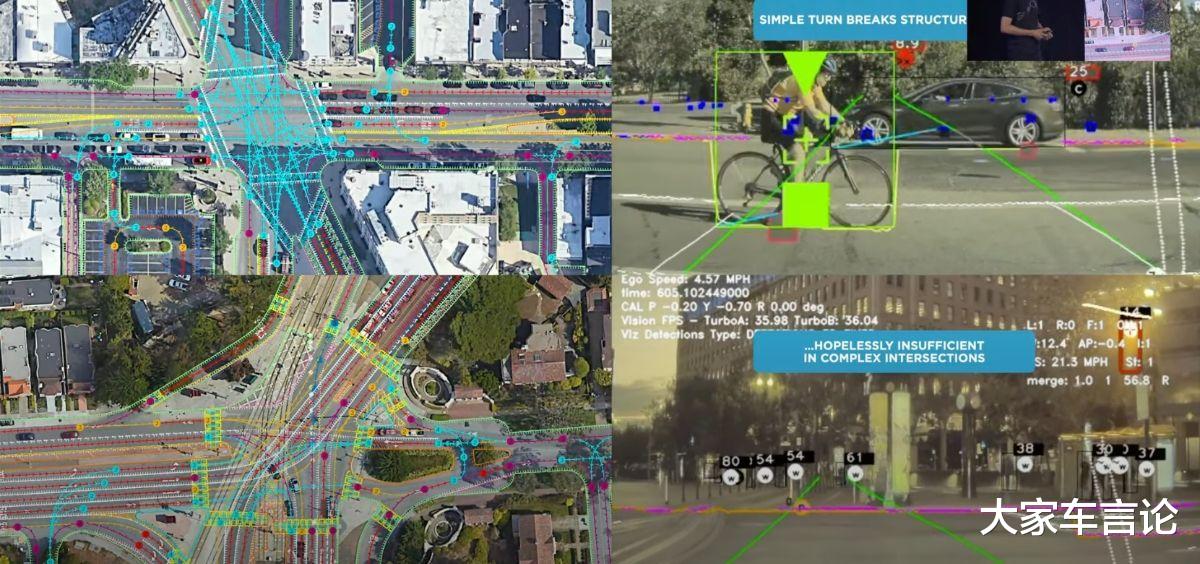

我认为 , “重感知轻地图”就是小鹏在驾驶辅助技术最大的转变 。 区别于特斯拉依靠摄像头的纯视觉路线 , 小鹏的外界感知能力来自于高精摄像头、毫米波雷达和激光雷达 。

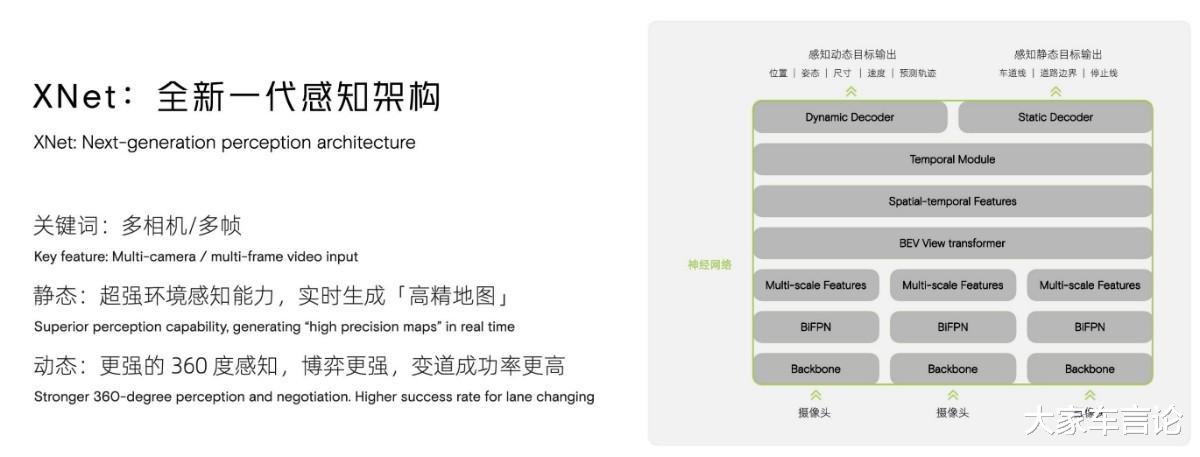

在讲解中 , 吴新宙博士反复提到了XNGP改用的全新一代感知架构XNet 。 这里面包括了几个频繁出现的关键词:神经网络、全自动标注系统、数据仿真以及Transformer模型 。

如果大家有关注过特斯拉的FSD , 你或许都会对这几个词印象深刻 。 就在月初的特斯拉AI Day上 , 特斯拉的工程师也花了相当长的时间 , 来介绍他们的神经网络系统 , 以及在自动标注、数据仿真、训练等方面的情况 。

用吴新宙博士的话说 , XNet深度视觉神经网络将多个摄像头采集的数据 , 进行多帧时序前融合 , 输出BEV视角(Bird's Eye View 俗称上帝视觉)下的动态目标物的4D信息(如车辆 , 二轮车等的大小、距离、位置及速度、行为预测等) , 以及静态目标物的3D信息(如车道线和马路边缘的位置) 。

按照我的理解 , 所谓的动态目标的4D信息 , 其实就是在原来的三维信息里面 , 加入了时间轴 , 这就像我们人的记忆 , 我们在开车时候 , 能看到旁边各个车辆和行人的连续运动轨迹 , 然后通过他们的轨迹 , 自然而然就能对他们接下来的行动方向有一定的预判性 。

具体地讲 , 就是对于提前防范那些突然变道的车辆和各种“乱入”的行人、电动车非常有帮助 。 通过XNet , 系统会具备实时产生高精地图的能力 , 这是用来克服无图场景高级城市辅助驾驶的最核心的能力 。

推荐阅读

- 这些革命性的技术可以在2030年之前改变我们的生活

- “撞不起”的新能源车!

- 电动车如果发生剐蹭事故,维修起来的价格真的是让人分分钟想死的节奏

- 尼古拉-特斯拉百年前的发明 直到如今 才发现其意义

- 辛吉飞为辛巴假燕窝洗白:他是被人坑了!网友:被充值了吧?

- 又一巨头下场造车:短短一年时间发布5款车,名字“碰瓷”特斯拉

- 特斯拉剐蹭撞车,余承东幸灾乐祸:“换华为汽车吧”

- 奥迪配件堪比死神镰刀 A6L的单目摄像头,更换价格10660,你敢想象吗?

- 1018万,说裁就裁!31岁探花,没球打了!